Test comparatif Tensorflow™ VGG16

LeaderGPU®, un service révolutionnaire qui vous permet d’aborder le calcul GPU sous un nouvel angle. La vitesse de calcul pour le modèle VGG16 avec LeaderGPU® est 1,8 fois plus rapide par rapport à Google Cloud, et 1,7 fois plus rapide par rapport à AWS (les données sont fournies pour un exemple avec 8x GTX 1080). Le coût de location à la minute du GPU sur LeaderGPU® commence à 0,02 euro seulement, ce qui est plus de 4 fois inférieur au coût de location de Google Cloud et plus de 5 fois inférieur au coût d’AWS (au 7 juillet 2017).

Tout au long de cet article, nous testerons le modèle VGG16 dans divers services proposant la location de GPU, notamment LeaderGPU®, AWS et Google Cloud. Les résultats des tests montrent pourquoi LeaderGPU® est l’offre la plus rentable parmi les options examinées.

Tous les tests ont été effectués en utilisant python 3.5 et Tensorflow-gpu 1.2 sur des machines configurées avec des cartes GTX 1080, GTX 1080 TI et Tesla® P100, le système d’exploitation CentOS 7 et la bibliothèque CUDA® 8.0.

Les commandes suivantes ont été utilisées pour exécuter les tests :

# git clone https://github.com/tensorflow/benchmarks.git# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2(Nombre de cartes sur le serveur) --model vgg16 --batch_size 32 (64)Instances GTX 1080

Dans le premier test, nous utilisons des instances avec la carte GTX 1080. Les données d’environnement de test (avec des tailles de lot 32 et 64) sont fournies ci-dessous :

Environnement de test :

- Types d’instance :ltbv17, ltbv13, ltbv16

- GPU: 2x GTX 1080, 4x GTX 1080, 8x GTX 1080

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub hash :b1e174e

- Benchmark GitHub hash :9165a70

- Commande :

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model vgg16 --batch_size 32 (optional 64) - Modèle :VGG16

- Date du test :Juin 2017

Les résultats du test sont présentés dans le diagramme suivant :'

Instances GTX 1080 Ti

Testons maintenant les instances avec la carte GTX 1080 Ti. Les données d’environnement de test (avec les tailles de lot 32 et 64) sont fournies ci-dessous :

Environnement de test :

- Types d’instance :ltbv21, ltbv18

- GPU:2x GTX 1080TI, 4x GTX 1080TI

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub hash :b1e174e

- Benchmark GitHub hash :9165a70

- Commande :

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 (4) --model vgg16 --batch_size 32 (optional 64) - Modèle :VGG16

- Date du test :Juin 2017

Les résultats du test sont présentés dans le diagramme suivant :'

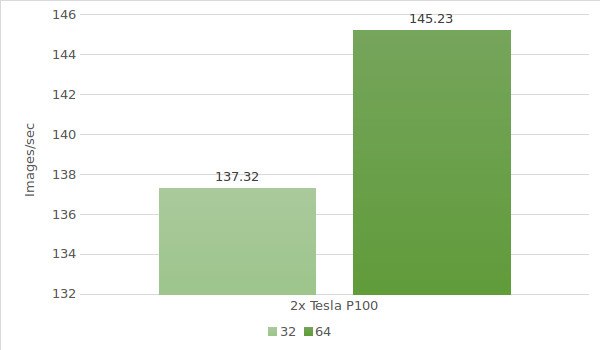

Instance Tesla® P100

Enfin, il est temps de tester les instances avec la carte Tesla® P100. Dans ce cas, l’environnement de test sera le suivant (avec des tailles de lot 32 et 64) :

Environnement de test :

- Type d’instance :ltbv20

- GPU:2x NVIDIA® Tesla® P100

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub hash :b1e174e

- Benchmark GitHub hash :9165a70

- Commande :

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model vgg16 --batch_size 32 (optional 64) - Modèle :VGG16

- Date du test :Juin 2017

Les résultats du test sont présentés dans le diagramme suivant :'

Le tableau ci-dessous montre les résultats des tests VGG16 sur Google Cloud et AWS :

| GPU | Google cloud | AWS |

|---|---|---|

| 1x Tesla K80 | 35.4 | 36.3 |

| 2x Tesla K80 | 64.8 | 69.4 |

| 4x Tesla K80 | 120 | 141 |

| 8x Tesla K80 | 234 | 260 |

* Données extraites des sources suivantes :

https://www.tensorflow.org/lite/performance/measurement#details_for_google_compute_engine_nvidia_tesla_k80

https://www.tensorflow.org/lite/performance/measurement#details_for_amazon_ec2_nvidia_tesla_k80

Nous calculerons le coût et le temps de traitement de 1 000 000 d’images sur chaque machine LeaderGPU®, AWS et Google (calcul basé sur le résultat le plus élevé de chaque machine) :

| GPU | Nombre d’images | Temps | Coût (par minute) | Coût total |

|---|---|---|---|---|

| 2x GTX 1080 | 1000000 | 96m 13sec | € 0,03 | € 2,89 |

| 4x GTX 1080 | 1000000 | 60m 17sec | € 0,02 | € 1,21 |

| 8x GTX 1080 | 1000000 | 38m 53sec | € 0,10 | € 3,89 |

| 4x GTX 1080TI | 1000000 | 41m 29sec | € 0,02 | € 0,83 |

| 2х Tesla P100 | 1000000 | 114m 45sec | € 0,02 | € 2,30 |

| 8x Tesla K80 Google cloud | 1000000 | 71m 12sec | € 0,0825** | € 4,84 |

| 8x Tesla K80 AWS | 1000000 | 64m 6sec | € 0,107 | € 6,85 |

** Le service Google Cloud n’offre pas de plans de paiement à la minute. Les calculs de coût à la minute sont basés sur le prix horaire (5 645 $).

Comme le montre le tableau, la vitesse de traitement d’image dans le modèle VGG16 est maximale sur 8x GTX 1080 de LeaderGPU®, tandis que :

le coût de location initial sur LeaderGPU® commence à seulement € 0,02 par minute, soit environ 4,13 fois moins que sur les instances de 8x Tesla® K80 de Google Cloud, et environ 5,35 fois moins que sur les instances de 8x Tesla® K80 de Google AWS ;

le temps de traitement était de 38 minutes 53 secondes, soit 1,8 fois plus rapide que sur les instances de 8x Tesla® K80 de Google Cloud, et 1,7 fois plus rapide que sur les instances de 8x Tesla® K80 de Google AWS.

Tout cela suggère que LeaderGPU® est beaucoup plus rentable que ses concurrents, permettant d’atteindre une vitesse maximale pour un coût optimal. Obtenez dès aujourd’hui le meilleur GPU avec une politique de tarification flexible sur LeaderGPU® !