Tensorflow™ – Inception V3-Benchmark

LeaderGPU® ist ein ehrgeiziger Akteur auf dem GPU-Computing-Markt, der den aktuellen Stand der Dinge ändern will. Nach den Testergebnissen ist die Berechnungsgeschwindigkeit für das Inception V3-Modell in LeaderGPU® im Vergleich zu Google Cloud 3-mal schneller und im Vergleich zu AWS 2,9-mal schneller (die Daten beziehen sich auf ein Beispiel mit 8 GTX 1080). Die Kosten für die Miete der GPUs in LeaderGPU® beginnen bei nur 0,02 Euro pro Minute, was mehr als 4-mal niedriger ist als die Kosten für die Miete in Google Cloud und mehr als 5-mal niedriger als die Kosten in AWS (Stand: 7. Juli).

In diesem Artikel testen wir das Inception V3-Modell in Diensten wie LeaderGPU®, AWS und Google Cloud. Wir werden sehen, warum LeaderGPU® das beste Angebot unter den untersuchten Optionen ist.

Alle Tests wurden mit Python 3.5 und Tensorflow-gpu 1.2 auf Rechnern mit GTX 1080, GTX 1080 Ti und Tesla® P 100 mit dem CentOS 7-Betriebssystem und der CUDA® 8.0-Bibliothek durchgeführt.

Die folgenden Befehle wurden zur Durchführung der Tests verwendet:

# git clone https://github.com/tensorflow/benchmarks.git# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2(Anzahl der Karten auf dem Server) --model inception3 --batch_size 32 (64, 128)GTX 1080-Instanzen

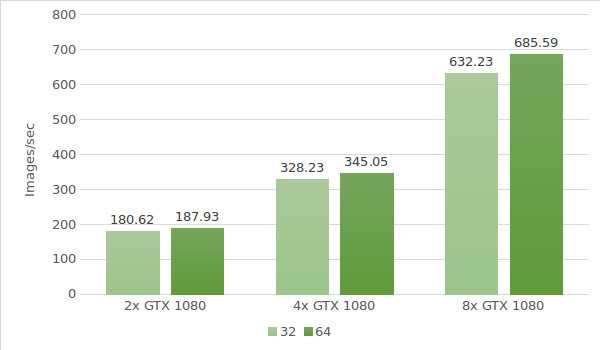

Für den ersten Test verwenden wir Instanzen mit GTX 1080. Die Daten der Testumgebung (mit den Stapelgrößen 32 und 64) sind unten aufgeführt:

- Instanztypen:ltbv17, ltbv13, ltbv16

- GPU: 2x GTX 1080, 4x GTX 1080, 8x GTX 1080

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub Hash:b1e174e

- Benchmark GitHub Hash:9165a70

- Befehl:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model inception3 –batch size 32 (optional 64) - Modell:Inception v3

- Datum des Tests:Juni 2017

Die Testergebnisse sind in dem folgenden Diagramm dargestellt:

GTX 1080 Ti-Instanzen

Wir setzen den Test mit GTX 1080 Ti-Instanzen fort. Die Daten der Testumgebung (mit den Stapelgrößen 32 und 64) sind unten aufgeführt:

- Instanztypen:ltbv21, ltbv18

- GPU: 2x GTX 1080TI, 4x GTX 1080TI

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub Hash:b1e174e

- Benchmark GitHub Hash:9165a70

- Befehl:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 (4) --model inception3 --batch_size 32 (optional 64, 128) - Modell:Inception v3

- Datum des Tests:Juni 2017

Die Testergebnisse sind in dem folgenden Diagramm dargestellt:

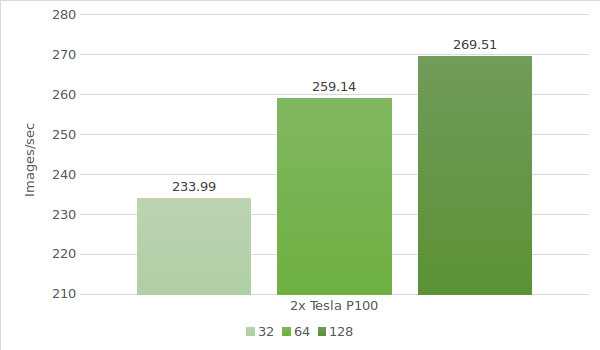

Tesla® P100-Instanz

Zum Schluss testen wir das Modell mit Tesla® P100. Die Daten der Testumgebung (mit den Stapelgrößen 32, 64 und 128) sind unten aufgeführt:

- Instanztypen:ltbv20

- GPU:GPU: 2x NVIDIA® Tesla® P100

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub Hash:b1e174e

- Benchmark GitHub Hash:9165a70

- Befehl:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model inception3 –batch size 32 (optional 64, 128) - Modell:Inception v3

- Datum des Tests:Juni 2017

Die Testergebnisse sind in dem folgenden Diagramm dargestellt:

In der nachstehenden Tabelle sind die Ergebnisse der Inception V3-Tests in Google Cloud und AWS (mit der Stapelgröße 64) zusammengefasst.

| GPU | Google cloud | AWS |

|---|---|---|

| 1x Tesla K80 | 30.5 | 30.8 |

| 2x Tesla K80 | 57.8 | 58.7 |

| 4x Tesla K80 | 116 | 117 |

| 8x Tesla K80 | 227 | 230 |

* Die Daten für die Tabelle stammen aus den folgenden Quellen:

https://www.tensorflow.org/lite/performance/measurement#details_for_google_compute_engine_nvidia_tesla_k80

https://www.tensorflow.org/lite/performance/measurement#details_for_amazon_ec2_nvidia_tesla_k80

Berechnen wir nun die Kosten und die Verarbeitungszeit von 1.000.000 Bildern auf einem LeaderGPU®-, AWS- und Google-Rechner. Das Zählen erfolgte auf allen Rechnern mit einer Stapelgröße von 64.

| GPU | Anzahl der Bilder | Zeit | Kosten (pro Minute) | Gesamtkosten |

|---|---|---|---|---|

| 2x GTX 1080 | 1000000 | 88m 41sec | € 0,03 | € 2,66 |

| 4x GTX 1080 | 1000000 | 48m 18sec | € 0,02 | € 0,97 |

| 8x GTX 1080 | 1000000 | 24m 18sec | € 0,10 | € 2,43 |

| 4x GTX 1080TI | 1000000 | 33m 47sec | € 0,02 | € 0,68 |

| 2х Tesla P100 | 1000000 | 64m 18sec | € 0,02 | € 1,29 |

| 8x Tesla K80 Google cloud | 1000000 | 73m 25sec | € 0,0825** | € 6,05 |

| 8x Tesla K80 AWS | 1000000 | 72m 27sec | € 0,107 | € 7,75 |

** Der Google Cloud-Dienst bietet keine minutenbasierten Zahlungspläne an. Die Berechnung der Kosten pro Minute basiert auf dem Stundenpreis (5,645 $).

Wie aus der Tabelle hervorgeht, ist die Bildverarbeitungsgeschwindigkeit im Inception V3-Modell mit 8 GTX 1080 in LeaderGPU® am höchsten. Hinzu kommt:

Die anfänglichen Kosten liegen in LeaderGPU® bei nur 1,77 €, was etwa 3,42-mal niedriger ist als bei den Instanzen mit 8 Tesla® K80 der Google Cloud-Plattform und etwa 4,38-mal niedriger als bei den Instanzen mit 8 Tesla® K80 in AWS.

Die Verarbeitungszeit betrug 24 Minuten und 18 Sekunden, was 3,03-mal schneller ist als bei den Instanzen mit 8 Tesla® K80 in Google Cloud und 2,99-mal schneller als bei den Instanzen mit 8 Tesla® K80 in AWS.

Die Testergebnisse lassen keine Zweifel aufkommen. LeaderGPU® ist ein bewährter Marktführer auf dem Gebiet des GPU-Computings und bietet konkurrenzlose Lösungen zu angemessenen Preisen. Profitieren Sie noch heute von dem kostengünstigen GPU-Angebot von LeaderGPU®!