Tensorflow™ – AlexNet-Benchmark

Die LeaderGPU®-Dienste sind darauf ausgerichtet, die Spielregeln des GPU-Computing-Marktes neu zu definieren. Dank der einzigartigen Eigenschaften der LeaderGPU®-Plattform werden Berechnungen für das AlexNet-Modell erstaunlich schnell ausgeführt – 2,3-mal schneller als in Google Cloud und 2,2-mal schneller als in AWS (die Daten beziehen sich auf 8 GTX 1080). Die Kosten für die GPU-Miete pro Minute in LeaderGPU® beginnen bei 0,02 Euro und sind damit 4,1-mal niedriger als in Google Cloud und 5,35-mal niedriger als in AWS (Stand: 7. Juli 2017).

In diesem Artikel stellen wir die Testergebnisse für das AlexNet-Modell in Diensten wie LeaderGPU®, AWS und Google Cloud vor. Sie werden verstehen, warum LeaderGPU® eine ideale Wahl für alle GPU-Computing-Anforderungen ist.

Alle Tests wurden mit Python 3.5 und Tensorflow-gpu 1.2 auf Rechnern mit GTX 1080, GTX 1080 Ti und Tesla® P 100 mit dem CentOS 7-Betriebssystem und der CUDA® 8.0-Bibliothek durchgeführt.

Die folgenden Befehle wurden zur Durchführung des Tests verwendet:

# git clone https://github.com/tensorflow/benchmarks.git# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=?(Anzahl der Karten auf dem Server) --model alexnet --batch_size 32 (64, 128, 256, 512)GTX 1080-Instanzen

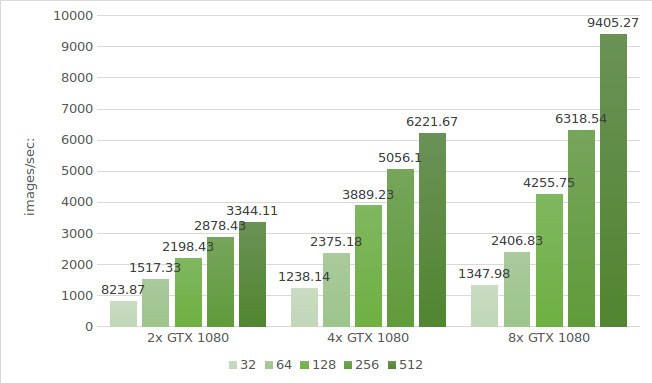

Der erste Test des AlexNet-Modells wird mit GTX 1080-Instanzen durchgeführt. Die Daten der Testumgebung (mit den Stapelgrößen 32, 64, 128, 256 und 512) sind unten aufgeführt:

Testumgebung:

- Instanztypen:ltbv17, ltbv13, ltbv16

- GPU: 2x GTX 1080, 4x GTX 1080, 8x GTX 1080

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub Hash:b1e174e

- Benchmark GitHub Hash:9165a70

- Befehl:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 (4,8) --model alexnet --batch_size 32 (optional 64, 128,256, 512) - Modell:Alexnet

- Datum des Tests:Juni 2017

Die Testergebnisse sind im nachstehenden Diagramm dargestellt:

GTX 1080 Ti-Instanzen

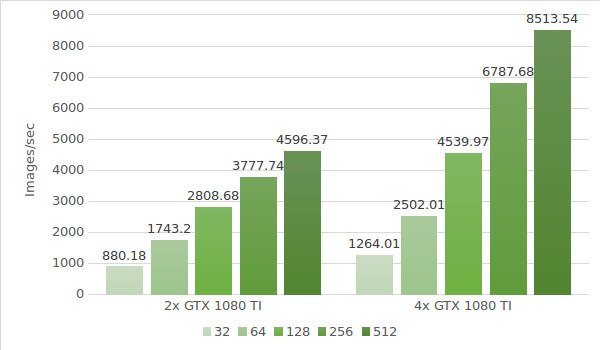

Im nächsten Schritt wird das AlexNet-Modell mit GTX 1080 Ti-Instanzen getestet. Die Daten der Testumgebung (mit den Stapelgrößen 32, 64, 128, 256 und 512) sind unten aufgeführt:

- Instanztypen:ltbv21, ltbv18

- GPU:2x GTX 1080TI, 4x GTX 1080TI

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub Hash:b1e174e

- Benchmark GitHub Hash:9165a70

- Befehl:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 (4) --model alexnet --batch_size 32 (optional 64, 128,256, 512) - Modell:Alexnet

- Datum des Tests:Juni 2017

Die Testergebnisse sind im nachstehenden Diagramm dargestellt:

Tesla® P100-Instanz

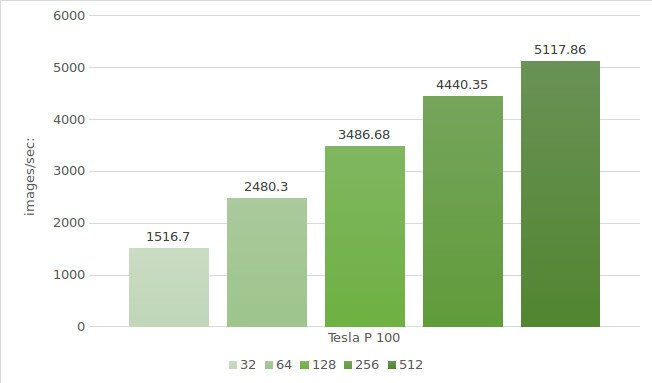

Zum Schluss wird das AlexNet-Modell mit Tesla® P100-Instanzen getestet. Die Testumgebung (mit den Stapelgrößen 32, 64, 128, 256 und 512) sieht wie folgt aus:

- Instanztyp:ltbv20

- GPU:2x NVIDIA® Tesla® P100

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub Hash:b1e174e

- Benchmark GitHub Hash:9165a70

- Befehl:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model alexnet --batch_size 32 (optional 64, 128, 256, 512) - Modell:Alexnet

- Datum des Tests:Juni 2017

Die Testergebnisse sind im nachstehenden Diagramm dargestellt:

Ähnliche AlexNet-Tests in Google Cloud und AWS ergaben folgende Ergebnisse:

| GPU | Google cloud | AWS |

|---|---|---|

| 1x Tesla K80 | 656 | 684 |

| 2x Tesla K80 | 1209 | 1244 |

| 4x Tesla K80 | 2328 | 2479 |

| 8x Tesla K80 | 4640 | 4853 |

* Die bereitgestellten Daten stammen aus den folgenden Quellen:

https://www.tensorflow.org/lite/performance/measurement#details_for_google_compute_engine_nvidia_tesla_k80

https://www.tensorflow.org/lite/performance/measurement#details_for_amazon_ec2_nvidia_tesla_k80

Berechnen wir nun die Kosten und die Verarbeitungszeit von 1.000.000 Bildern auf einem LeaderGPU®-, AWS- und Google-Rechner. Für die Berechnung wurde das höchste Ergebnis der einzelnen Rechner genutzt.

| GPU | Anzahl der Bilder | Zeit | Kosten (pro Minute) | Gesamtkosten |

|---|---|---|---|---|

| 2x GTX 1080 | 1000000 | 5m | € 0,03 | € 0,15 |

| 4x GTX 1080 | 1000000 | 2m 40sec | € 0,02 | € 0,05 |

| 8x GTX 1080 | 1000000 | 1m 46sec | € 0,10 | € 0,18 |

| 4x GTX 1080TI | 1000000 | 2m 5sec | € 0,02 | € 0,04 |

| 2х Tesla P100 | 1000000 | 3m 15sec | € 0,02 | € 0,07 |

| 8x Tesla K80 Google cloud | 1000000 | 3m 35sec | € 0,0825** | € 0,29 |

| 8x Tesla K80 AWS | 1000000 | 3m 26sec | € 0,107 | € 0,36 |

** Der Google Cloud-Dienst bietet keine minutenbasierten Zahlungspläne an. Die Berechnung der Kosten pro Minute basiert auf dem Stundenpreis (5,645 $).

Wie aus der Tabelle hervorgeht, ist die Bildverarbeitungsgeschwindigkeit im VGG16-Modell mit 8 GTX 1080 in LeaderGPU® am höchsten. Hinzu kommt:

Die anfänglichen Mietkosten liegen bei LeaderGPU® bei nur 1,92 €, was etwa 2,5-mal niedriger ist als bei den Instanzen mit 8 Tesla® K80 der Google Cloud-Plattform und etwa 3,6-mal niedriger als bei den Instanzen mit 8 Tesla® K80 in AWS.

Die Verarbeitungszeit betrug 38 Minuten und 53 Sekunden, was 1,8-mal schneller ist als bei den Instanzen mit 8 Tesla® K80 in Google Cloud und 1,7-mal schneller als bei den Instanzen mit 8 Tesla® K80 in AWS.

Aus diesen Fakten lässt sich schließen, dass LeaderGPU® im Vergleich zu seinen Konkurrenten viel profitabler ist. Mit LeaderGPU® erhalten Sie maximale Geschwindigkeit zu optimalen Preisen. Mieten Sie noch heute die besten GPUs zu flexiblen Preisen bei LeaderGPU®!